python - pandas讀取中文的時候亂碼 要如何解決?

問題描述

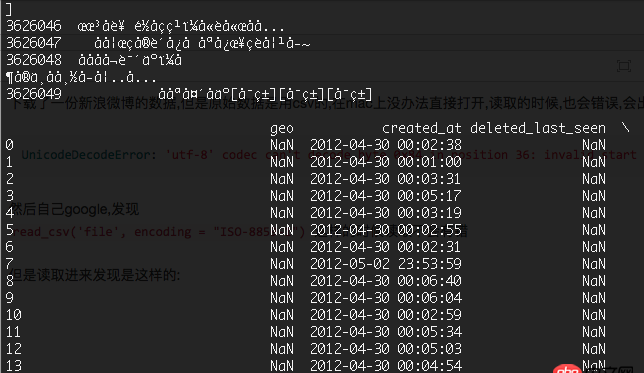

下載了一份新浪微博的數(shù)據(jù),但是原始數(shù)據(jù)是用csv的,在mac上沒辦法直接打開,讀取的時候,也會錯誤,會出現(xiàn)

UnicodeDecodeError: ’utf-8’ codec can’t decode byte 0x84 in position 36: invalid start byte

然后自己google,發(fā)現(xiàn)read_csv(’file’, encoding = 'ISO-8859-1') 這樣的時候讀取不會有錯

但是讀取進(jìn)來發(fā)現(xiàn)是這樣的:

中文全部

然后測試了read_csv(’file’, encoding = 'gbk')read_csv(’file’, encoding = 'utf8')read_csv(’file’, encoding = 'gb18030')總之就是各種不行~基本的情況如下:

UnicodeDecodeError: ’gb18030’ codec can’t decode byte 0xaf in position 12: incomplete multibyte sequence

有大神遇到類似的情況嗎?

有大神說要數(shù)據(jù) 因?yàn)楸容^大,熱心的人可以看看 不過我覺得挺有用的下面是微博的數(shù)據(jù)鏈接:http://pan.baidu.com/s/1jHCOwCI 密碼:x58f

補(bǔ)充一下代碼吧~上面隨意一個文件下載下來(是csv格式的)然后用pandas打開就會出錯~

import pandasdf = pandas.read_csv('week1.csv')

問題解答

回答1:給代碼和原數(shù)據(jù)

你寫點(diǎn)能代碼+有代表性的數(shù)據(jù) 即可,別搞幾G的大數(shù)據(jù)阿~

誰看啊?

回答2:跟你一樣的情況,試了很多編碼仍然沒有用,但是看數(shù)據(jù)用UTF8編碼的話,有的數(shù)據(jù)能轉(zhuǎn)換成功,所以我暫時能想到的辦法就是用open去按行讀取,如果出現(xiàn)編碼轉(zhuǎn)換錯誤就丟掉,這樣下來數(shù)據(jù)量其實(shí)也不少

回答3:你也可以試試用cp1252。最好的方法是先通過chardet包(https://pypi.python.org/pypi/...)看文件具體上用什么encoding。

回答4:試過了沒有問題呀,我猜想應(yīng)該是你環(huán)境編碼問題吧,可以嘗試一下以下代碼

#coding=utf-8import pandas as pdimport sysreload(sys)sys.setdefaultencoding('utf-8')df = pd.read_csv(’week1.csv’, encoding=’utf-8’, nrows=10)print df

相關(guān)文章:

1. python執(zhí)行cmd命令,怎么讓他執(zhí)行類似Ctrl+C效果將其結(jié)束命令?2. python - Flask寫的注冊頁面,當(dāng)注冊時,如果填寫數(shù)據(jù)庫里有的相同數(shù)據(jù),就報錯3. python - Django有哪些成功項(xiàng)目?4. python - scrapy url去重5. 實(shí)現(xiàn)bing搜索工具urlAPI提交6. MySQL主鍵沖突時的更新操作和替換操作在功能上有什么差別(如圖)7. mysql在限制條件下篩選某列數(shù)據(jù)相同的值8. 關(guān)于mysql聯(lián)合查詢一對多的顯示結(jié)果問題9. 數(shù)據(jù)庫 - Mysql的存儲過程真的是個坑!求助下面的存儲過程哪里錯啦,實(shí)在是找不到哪里的問題了。10. Python從URL中提取域名

網(wǎng)公網(wǎng)安備

網(wǎng)公網(wǎng)安備